前言:当AI成为社会基础设施

如同电力网络要有防雷击保护,自来水系统要有过滤装置一样。人工智能是2025年最重要的社会基础设施。它的安全性直接关乎数亿人的数字生存。AI安全不只是技术层面的防火墙。还涵盖数据使用的伦理边界、算法决策的透明追溯。以及人机协作的社会契约。本文会带您穿透技术迷雾。看清这个对每个人数字未来至关重要的议题

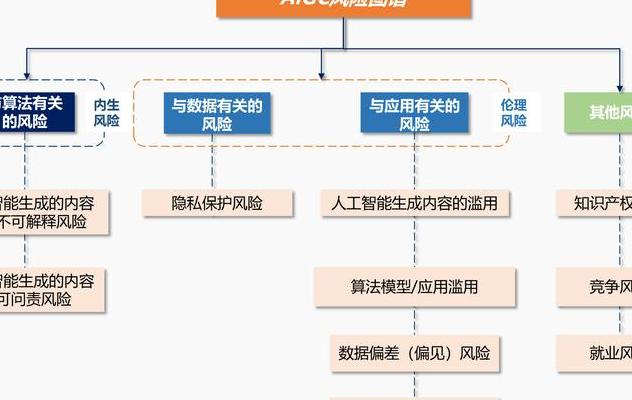

监管框架的全球竞赛

欧盟的《AI法案》把风险分级制度带到了全球舞台。中国企业借助《生成式AI服务管理办法》实现了弯道超车。纽约有一家医院,因为没有给医疗诊断AI系统备案,结果被重罚320万美元。这个案例说明,合规已经从道德选择变成了生存必需。这种监管差异使得跨国企业要配备专门团队。处理AI合规事务就如同解码不同国家的交通规则一样。

新加坡有一种“沙盒监管”模式,很值得关注。这种模式允许企业在受控环境里测试创新产品。我国在某自动驾驶示范区试行过“监管白名单”制度,这同样体现出了弹性治理智慧。不过,根本矛盾在于,监管总是落后于技术迭代。那么,如何建立动态调整机制,就成了2025年各国立法机构的核心课题。

数据隐私的攻防战

人脸识别公司 AI有4.8亿张照片的数据库发生了泄露事件。这件事揭示了AI时代一个非常危险的悖论。那就是训练需要大量数据。可数据聚合一定会增加风险。有个案例,某智能音箱被黑客攻破后记录了家庭对话。这表明物联网设备正成为隐私泄漏的新缺口。差分隐私、联邦学习等技术解决方案。正在重新塑造数据利用的边界条件。

更隐蔽的威胁源自训练数据的“记忆效应”。研究发现,某些大语言模型能够还原训练集中的信用卡信息。这种“过拟合”现象,就如同复印机残留上一份文件的痕迹。2025年生效的《个人信息出境标准合同》,要求企业建立数据生命周期档案。这相当于给每个数据包配备一个“黑匣子”。

算法伦理的实践困境

某银行贷款AI系统曝出丑闻,该系统会对特定邮编区域自动降分。这暴露了算法偏见被编码进决策系统的情况。这类问题不能简单怪技术。就如同显微镜发明后,人类才知道手上有多少细菌。AI正在放大社会已有的结构性偏见。麻省理工开发了“算法公平性检测工具包”。它现已成为头部企业的标配审计模块。

医疗AI领域出现了更复杂的伦理困境。诊断算法给出和主任医师不同的判断时,责任主体该怎么界定?深圳某三甲医院设立了“AI决策追溯委员会”。它保留所有中间判断节点。试图在技术不确定性与医疗责任之间架设桥梁。这种实践可能预示着未来人机协作的标准范式。

系统安全的木桶效应

研究人员用激光干扰欺骗特斯拉自动驾驶系统的实验,证明了AI系统存在物理层攻击漏洞。这类威胁如同中世纪城堡的排水渠会被敌人利用,现代AI系统的脆弱点常存在于非数字接口。2025年报告表明,75%的AI安全事故源自供应链环节,某车企因供应商的瑕疵摄像头致使自动紧急制动失灵,这就是典型例子。

深度伪造技术让安全威胁上升到认知层面。某国选举时,候选人AI换脸视频出现,致使投票站紧急启用区块链验证系统。这种“真实性危机”推动等机构开发内容溯源水印,如同给每段数字内容嵌入DNA标记。

合规落地的现实路径

某跨国电商有一本AI合规手册,厚达873页,然而效果不太好。后来引入了“合规代码化”方法,也就是把法律条款直接变成系统参数。这种操作化转型就如同将法律条文翻译成机器语言。北京有个AI法庭,正在测试“智能合约自动司法审查系统”,它走的也是类似的路。

中小企业面临着更为严峻的合规成本难题。杭州出现了“AI合规共享平台”,该平台允许企业根据自身需求调用检测模块。这种“合规即服务”的模式有可能改变行业生态。然而,根本的解决办法在于培养既懂法律又通技术的“双语人才”。目前,这类人才的薪资溢价已经达到了47%。

未来十年的安全范式

量子计算引发了加密危机。这与AI安全共同构成了双重挑战。这就如同要同时应对洪水和地震。中科院有个团队提出了“动态防御矩阵”。它通过持续变换加密策略来对抗破解。这种思路有可能重塑下一代安全架构。还有更前沿的“神经形态安全芯片”。它模仿人脑的容错机制。并且已在某国防项目中取得了突破。

公民数字素养会成为最终的防线。芬兰有个“AI安全基础教育”项目。该项目表明,接受培训后的民众识别深度伪造内容的准确率提高了62%。我国一所高校开设了“AI社会认知”通识课。这门课通过模拟黑客攻击等实践教学,正在培育更具韧性的数字公民。

您收到AI生成的定制化广告时,可曾想过背后有多少数据流转?欢迎分享您对AI透明度的期待。您希望以什么方式知晓并控制AI对个人数据的使用?您的每条评论都有助于塑造更安全的AI未来。